Mixtral 8x7B: il modello open-source più potente per la generazione di testi

Se siete appassionati di intelligenza artificiale e di generazione di testi, probabilmente avete sentito parlare di Mistral AI, una società che si occupa di creare e condividere modelli aperti di alta qualità per la comunità degli sviluppatori. Mistral AI ha recentemente rilasciato Mixtral 8x7B, un modello innovativo basato su una tecnica chiamata sparse mixture of experts (SMoE), che gli permette di avere un numero elevato di parametri pur mantenendo un costo e una latenza contenuti.

Mixtral 8x7B è un modello decoder-only, cioè in grado di generare testi a partire da un input, ma non di analizzare o classificare testi esistenti. Il modello ha un totale di 46.7 miliardi di parametri, ma ne usa solo 12.9 miliardi per ogni token, grazie al fatto che il blocco feedforward sceglie da un insieme di 8 gruppi distinti di parametri (gli “esperti”) e ne combina l’output in modo additivo. Questo significa che Mixtral 8x7B ha la stessa velocità e lo stesso costo di un modello da 12.9 miliardi, ma con una qualità superiore.

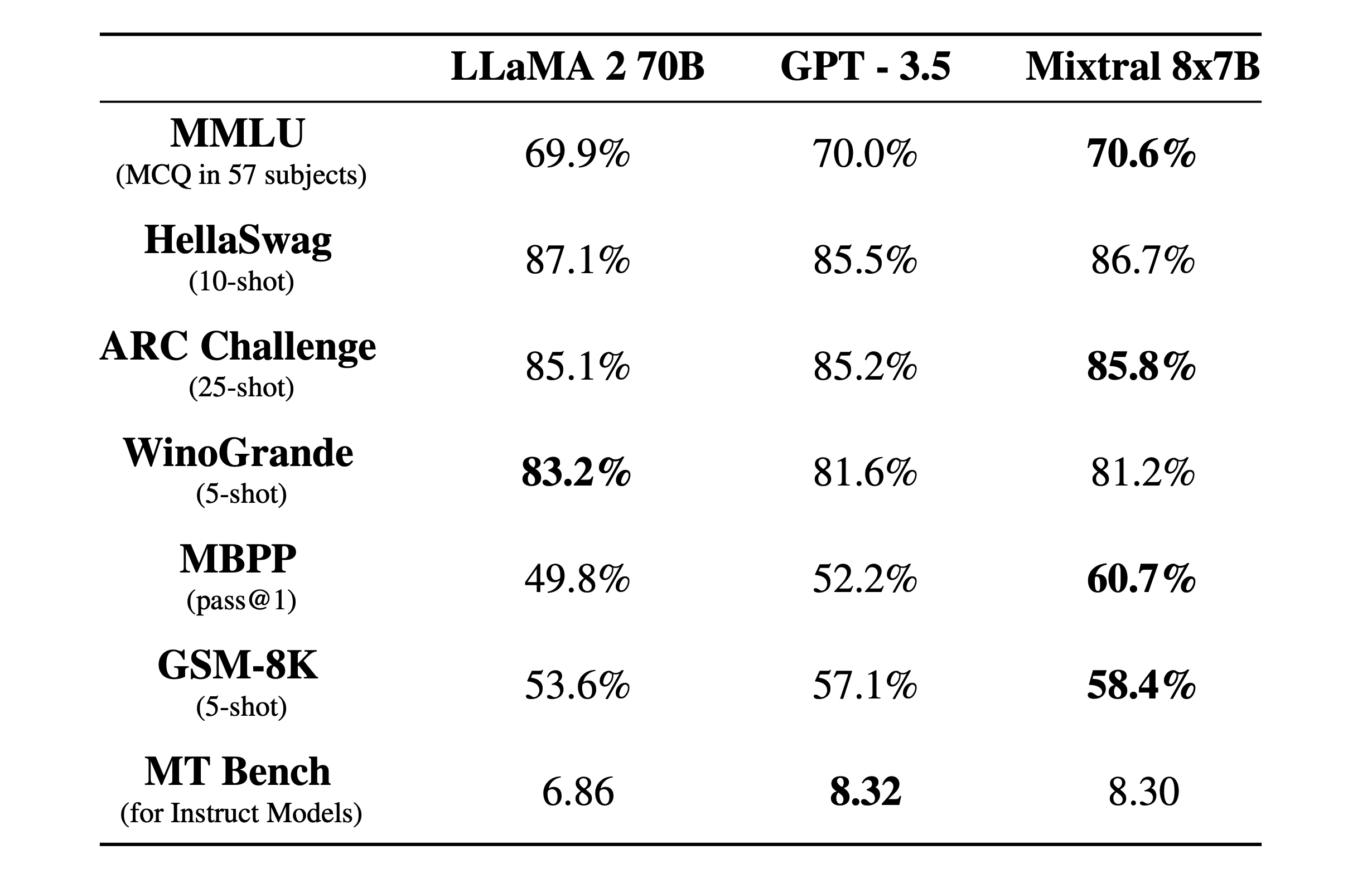

Mixtral 8x7B è stato pre-addestrato su dati estratti dal Web aperto, e ha dimostrato di superare o eguagliare altri modelli famosi, come Llama 2 70B e GPT3.5, su diverse metriche standard, come il punteggio GLUE, il punteggio LAMBADA e il punteggio WikiText-103. Inoltre, Mixtral 8x7B ha mostrato di essere più veritiero e meno prevenuto di Llama 2, e di padroneggiare diverse lingue, tra cui l’inglese, il francese, il tedesco, lo spagnolo e l’italiano.

Mistral AI ha anche rilasciato Mixtral 8x7B Instruct, una versione ottimizzata di Mixtral 8x7B per seguire istruzioni complesse e generare contenuti creativi e coerenti. Questo modello ha raggiunto un punteggio di 8.30 su MT-Bench, rendendolo il miglior modello open-source per il seguimento di istruzioni, con una performance paragonabile a quella di GPT3.5.

Mixtral 8x7B e Mixtral 8x7B Instruct sono entrambi disponibili con una licenza Apache 2.0, che ne permette l’uso e la modifica liberamente. Per facilitare l’uso di questi modelli con uno stack completamente open-source, Mistral AI ha contribuito al progetto vLLM, che integra i kernel CUDA di Megablocks per un’inferenza efficiente. Inoltre, Mistral AI offre la possibilità di usare i suoi modelli tramite Skypilot, una piattaforma che consente il deployment di endpoint vLLM su qualsiasi istanza nel cloud.

Mixtral 8x7B è un modello rivoluzionario, che apre nuove possibilità per la ricerca e lo sviluppo nell’ambito dell’intelligenza artificiale.